声明: 本文由( admin )原创编译,转载请保留链接: robots协议

玩转网站搭建,熟练技巧秒建站

玩转网站搭建,熟练技巧秒建站 seo文章优化技巧,高质量内容创造

seo文章优化技巧,高质量内容创造 做SEO一路走来的坚持与希望

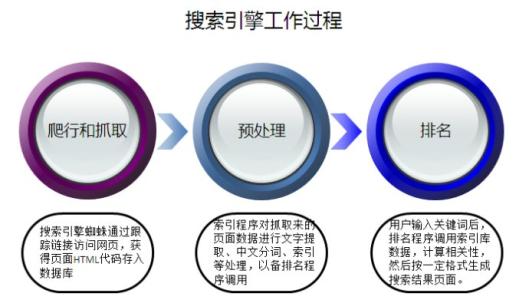

做SEO一路走来的坚持与希望 做SEO必知的搜索引擎排名原理

做SEO必知的搜索引擎排名原理 strong标签和b标签

strong标签和b标签.jpg) 网站外链怎么做?

网站外链怎么做? 武汉seo优化网站怎么做?这些技巧助你排名

武汉seo优化网站怎么做?这些技巧助你排名 SEO小白看这里网站后台秒懂操作

SEO小白看这里网站后台秒懂操作

博主:墨沉 行业:互联网 品牌:墨沉SEO

我是周小雷 , 笔名"墨沉"

取自"腹中有墨,不愿沉沦"之意。

我一直有一颗90后浪漫主义者的心

梦里寻她千百度,蓦然回首,那人却在灯火阑珊处。

爱好互联网,写自传、现代诗词等。

小墨专注电子商务、武汉SEO优化、武汉SEO服务、武汉SEO顾问、微营销、淘宝运营、网站运营、网络营销、网络推广、微信公众号、营销系统研发和培训;小墨致力于帮助草根网络创业者打造最好的网络营销系统! 用思维改变命运!

小墨免费提供企业、论坛、博客等网站SEO服务诊断,欢迎大家咨询。墨沉SEO-微信:szjhke

或联系QQ:1194285866

如何快速的写出一个优质的网站标题

如何快速的写出一个优质的网站标题 网站栏目规划关键词

网站栏目规划关键词 strong标签和b标签

strong标签和b标签 404错误怎么解决?

404错误怎么解决? seo文章优化技巧,高质量内容创造

seo文章优化技巧,高质量内容创造 建站篇:织梦安装步骤详细教程说明

建站篇:织梦安装步骤详细教程说明 strong标签如何添加

strong标签如何添加 做SEO优化买域名和空间的选择技巧

做SEO优化买域名和空间的选择技巧 网站关键词排名查询

网站关键词排名查询 搜索引擎优化学习五大招,快速掌握排名

搜索引擎优化学习五大招,快速掌握排名